Nous présentons les meilleurs tests possibles sur le paramètre \(p\) d’une loi de Bernoulli, tests exacts, pour les Alternatives 1a et les Alternatives 1b. Soit \(X\) une v.a. de loi \({\cal B}(1\ ;\ p)\), avec \(p\in\rbrack 0\;\ 1\lbrack\). C’est l’indicatrice d’un événement de probabilité \(p\). Soit \(X_{\bullet}=(X_1,\cdots,X_n)\) un \(n-\)échantillon de \(X\).

Propriété 1. La loi \({\cal B}(1\ ;\ p)\) est de type exponentiel à rapport de vraisemblance croissant par rapport à la statistique \(T(X_{\bullet})=\sum_{j=1}^nX_j\).

Pour le voir il suffit de constater que, pour \(p\in\rbrack 0\;\ 1\lbrack\) et \(x=0,\ 1\), nous avons :

et pour \(p,\ p^{\prime}\in\rbrack 0\;\ 1\lbrack\), avec \(p<p^{\prime}\), nous avons :

qui est croissante par rapport à \(T(X_{\bullet})=\sum_{j=1}^nX_j.\ \square \)

Remarquons que la statistique \(T(X_{\bullet})\) est le nombre de «un» ou «succès» dans l’échantillon et que \({\cal L}_p(T(X_{\bullet}))={\cal B}(n\ ;\ p)\), loi Binomiale de paramètres \(n\) et \(p\).

Alternative 1a.

Soit \(p_0\in\rbrack 0\ ;\ 1\lbrack\) donné et \(\alpha\in \rbrack 0\ ;\ 1\lbrack\) un seuil fixé. Pour tester l’alternative :

ainsi que les autres Alternatives 1a associées, nous considérons le test \(\psi^{(1a)}_{\ast}(x_{\bullet})=\gamma_{\alpha}I_{\lbrace T(x_{\bullet})=c_{\alpha}\rbrace}(T(x_{\bullet}))+I_{\rbrack c_{\alpha}\ ;\ n\rbrack}(T(x_{\bullet}))\), où la valeur critique \(c_{\alpha}\in\lbrace 0,\ 1,\ \cdots,\ n\rbrace\) et la probabilité critique \(\gamma_{\alpha}\in \lbrack 0\ ;\ 1\rbrack\) sont définies par la relation :

Ainsi :

Remarque 1. Décider «\({\cal H}_1^{(1a)}\) est vraie» avec une probabilité \(\gamma_{\alpha}\), consiste à réaliser une simulation \(u\) d’une loi uniforme continue \({\cal U}(\rbrack 0\ ;\ 1\lbrack)\), par exemple avec la commande de R runif, et

Nous pouvons poser \(\gamma_{\alpha}=1\) et alors si \(c_{\alpha} = T(x_{\bullet})\), nous décidons «\({\cal H}_1^{(1a)}\) est vraie» ; le test devient non aléatoire mais le seuil est supérieur à \(\alpha\).

Remarque 2. Si pour l’utilisateur décider à tort que le paramètre \(p\) est supérieur à une valeur fixée \(p_0\) a les conséquences les plus défavorables, c’est sur ce test \(\psi^{(1a)}_{\ast}\) qu’il doit fonder sa démarche.

Propriété 2. Le test \(\psi^{(1a)}_{\ast}\) est le meilleur test possible pour l’Alternative 1a et la loi de Bernoulli. Il est de seuil \(\alpha\), sans biais pour ce seuil, U.P.P. et convergent. De plus sa fonction puissance est donnée par :

C’est une application directe de la Propriété 1 ci-dessus et de la Propriété 2 des tests paramètriques unilatéraux.\(\ \square\)

Remarque 3. Les nombres critiques \(c_{\alpha}\) et \(\gamma_{\alpha}\) sont uniques. Le nombre \(c_{\alpha}\) est le plus petit nombre \(t\) tel que \(P_{p_0}(t < T(x_{\bullet}))< \alpha\) et \(\gamma_{\alpha}=\dfrac{\alpha-P_{p_0}(c_{\alpha} < T(X_{\bullet}))}{P_{p_0}(T(X_{\bullet})=c_{\alpha})}\).

Remarque 4. Si nous avons observé \(T(x_{\bullet})=t_0\), comme \(\dfrac{T(x_{\bullet})}{n}\) est le meilleur estimateur de \(p\), la puissance a posteriori est donnée par :

Remarque 5. Si nous considérons les alternatives :

qui sera étudiée ci-après, alors les tests \(\psi^{(1a)}_{\ast}\), au seuil \(\alpha\), et \(1-\psi^{(1b)}_{\ast}\), au seuil \(1-\alpha\), sont identiques.

Propriété 3. Si nous avons observé \(T(x_{\bullet})=t_0\), alors la décision avec les «\(p-\)valeurs» se prend de la manière suivante :

Pour une décision non aléatoire :

Remarque 6. Nous avons créé dans R quatre procédures. Les deux premières Test1aBern1p et Test1aBern1p_Int, permettent de réaliser le test avec une exécution non interactive et interactive respectivement. Les deux autres Puis1aBern1p et Puis1aBern1p_Int, permettent le calcul de la puissance avec une exécution non interactive et interactive respectivement.

Exemple 1. Nous reprenons le même exemple que celui du test asymptotique correspondant. Une entreprise doit livrer un lot de pièces. Un contrôle statistique de conformité est mis en place. Le lot est conforme si moins de \(4 \%\) des pièces sont défectueuses. Nous admettons que la situation la plus défavorable pour le livreur est celle de décider à tort que le lot n’est pas conforme. Donc nous nous proposons de tester l’alternative :

Nous avons, sur \(70\) pièces choisies au hasard dans le lot, \(3\) pièces non conformes. Nous fixons un seuil à \(0,05\) et nous exécutons, après les avoir compilées («sourcée» dans R), les procédures de la Remarque 6 ci-dessus.

Test1aBern1p(3,70,.04,.05), réponse :

Test de l’alternative : H0(1a)={ p ⩽ 0.04 } contre H1(1a)={ 0.04 < p }.

Taille de l’échantillon : 70 ; nombre de «un» : 3 ; estimation du paramètre : 0.04286 .

Seuil du test : 0.05 ; valeur critique : 6 ; probabilité critique : 0.7158 .

Décision : «H0(1a) est vraie» .

La puissance a posteriori est : 0.06549 .

La procédure interactive donne quant à elle :

Test1aBern1p_Int(), réponse :

Saisir le nombre de «un» : 3, réponse :

Saisir la taille de l’échantillon : 70, réponse :

Saisir la proportion P0 : .04, réponse :

Saisir seuil du test : .05, réponse :

les mêmes résultats que ceux de la procédure non interactive sont alors affichés.

La décision est «\({\cal H}_0^{(1a)}\) est vraie». Le test n’est pas significatif. La puissance a posteriori est très faible : 0,06549. Nous avons les mêmes conclusions que le test asymptotique. Notons que le test ici est le plus puissant. Il n’y a aucune raison objective de ne pas livrer le lot ; mais la décision est risquée. Pour être plus sûrs il faudrait refaire un échantillonnage.

La décision n’est pas aléatoire. A titre d’exemple nous présentons le même test, dans la même situation pratique, mais avec un échantillon différent. La taille de cet échantillon est \(n=20\) est le nombre de «un» est \(k=2\). Voici les résultats :

Test1aBern1p(2,20,.04,.05), réponse :

Test de l’alternative : H0(1a)={ p ⩽ 0.04 } contre H1(1a)={ 0.04 < p }.

Taille de l’échantillon : 20 ; nombre de «un» : 2 ; estimation du paramètre : 0.1 .

Seuil du test : 0.05 ; valeur critique : 2 ; probabilité critique : 0.04209 .

La décision est aléatoire avec la simulation uniforme U= 0.3202 .

Le seuil réel si la décision aléatoire est rendue non aléatoire : 0.1897 .

Décision : «H0(1a) est vraie» .

La puissance a posteriori est : 0.3351 .

La procédure interactive quant à elle est identique et donne les mêmes résultats. Le nombre de «un» observés et égal à la valeur critique \(k=c_{\alpha}=2\). La probabilité critique est \(\gamma_{\alpha}=0,04209\) ; comme la simulation uniforme est \(u=0,3202\), nous avons la même décision que celle à partir du premier échantillon. Cependant si nous décidons d’effectuer un test non aléatoire dans ce cas, alors la décision est «\({\cal H}_1^{(1a)}\) est vraie» mais le seuil réel du test est \(\alpha=0,1897\), c’est-à-dire que le risque de première espèce est nettement plus grand.

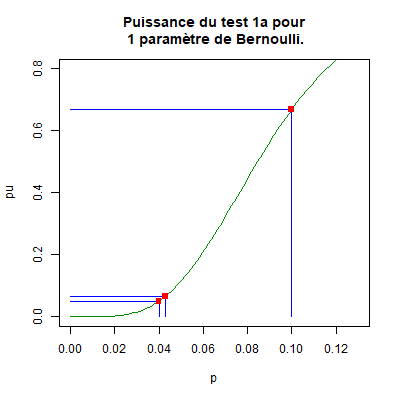

Nous revenons au premier échantillon. Nous calculons la puissance pour les points \(p=0,04286\) et \(p=0,1\) par exemple. Nous exécutons, après les avoir compilées («sourcée» dans R), les procédures de la Remarque 6 ci-dessus.

Puis1aBern1p(70,0.04,0.05,0.04286), réponse : 0.06551 .

Puis1aBern1p(70,0.04,0.05,0.1), réponse : 0.6689 .

La procédure interactive donne, par exemple :

Puis1aBern1p_Int(), réponse :

Saisir la taille de l’échantillon : 70, réponse :

Saisir la proportion P0 : .04, réponse :

Saisir seuil du test : .05, réponse :

Saisir le point P où calculer une approximation de la puissance asymptotique : 0.1, réponse : 0.6689 .

Le test exact étant U.P.P., c’est sa puissance qui est prépondérante et non celle du test asymptotique qui est approximative. Nous pouvons également tracer le graphique de la fonction puissance du test avec les commandes suivantes :

plot(

function(p)

Puis1aBern1p(70,0.04,0.05,P), 0, 0.13,

xlab="p",

ylab="pu",

ylim=

c(0,0.8),

main=Puissance du test 1a pour\n 1 paramètre de Bernoulli.",

col="green4");

x0=c(0.04,0.04,0.04286,0.04286,0.1,0.1);

y0=c(0,0.05,0,0.06551,0,.6689);

x1=c(0.04,0,0.04286,0,0.1,0);

y1=c(0.05,0.05,0.06551,0.06551,0.6689,0.6689);

segments(x0,y0,x1,y1,

col="blue");

points(

x=c(0.04,0.04286,0.1),

y=c(0.05,0.06551,0.6689),

col="red",

pch='.',

cex=8), réponse :

Nous avons marqué en rouge les points \((p_0\ ;\ \alpha)=(0,04\ ;\ 0,05)\), \((0,1\ ;\ pu_{\psi^{(1a)}_{\ast}}(0,1))=(0,1\ ;\ 0,0.6689)\) et \((0,04286\ ;\ pu_{\psi^{(1a)}_{\ast}}(0,04286))=(0,04286\ ;\ 0,0.06551)\). Nous constatons, entre autres, que le test est de seuil \(0,05\) et sans biais. \(\ \square\)

Alternative 1b.

Soit \(p_0\in\rbrack 0\ ;\ 1\lbrack\) donné et \(\alpha\in \rbrack 0\ ;\ 1\lbrack\) un seuil fixé. Pour tester l’alternative :

ainsi que les autres Alternatives 1b associées, nous considérons le test \(\psi^{(1b)}_{\ast}(x_{\bullet})=\gamma_{\alpha}I_{\lbrace T(x_{\bullet})=c_{\alpha}\rbrace}(T(x_{\bullet}))+I_{\lbrack 0\ ;\ c_{\alpha}\lbrack}(T(x_{\bullet}))\), où la valeur critique \(c_{\alpha}\in\lbrace 0,\ 1,\ \cdots,\ n\rbrace\) et la probabilité critique \(\gamma_{\alpha}\in \lbrack 0\ ;\ 1\rbrack\) sont définies par la relation :

Ainsi :

Remarque 7. Décider «\({\cal H}_1^{(1b)}\) est vraie» avec une probabilité \(\gamma_{\alpha}\), consiste à réaliser une simulation \(u\) d’une loi uniforme continue \({\cal U}(\rbrack 0\ ;\ 1\lbrack)\), par exemple avec la commande de R runif, et

Nous pouvons poser \(\gamma_{\alpha}=1\) et alors si \(c_{\alpha} = T(x_{\bullet})\), nous décidons «\({\cal H}_1^{(1b)}\) est vraie» ; le test devient non aléatoire mais le seuil est supérieur à \(\alpha\).

Remarque 8. Si pour l’utilisateur décider à tort que le paramètre \(p\) est inférieur à une valeur fixée \(p_0\) a les conséquences les plus défavorables, c’est sur ce test \(\psi^{(1b)}_{\ast}\) qu’il doit fonder sa démarche.

Propriété 4. Le test \(\psi^{(1b)}_{\ast}\) est le meilleur test possible pour l’alternative 1a et la loi de Bernoulli. Il est de seuil \(\alpha\), sans biais pour ce seuil, U.P.P. et convergent. De plus sa fonction puissance est donnée par :

C’est une application directe de la Propriété 1 ci-dessus et de la Propriété 2 des tests paramètriques unilatéraux.\(\ \square\)

Remarque 9. Les nombres critiques \(c_{\alpha}\) et \(\gamma_{\alpha}\) sont uniques. Le nombre \(c_{\alpha}\) est le plus grand nombre \(t\) tel que \(P_{p_0}(T(x_{\bullet}) < t)< \alpha\) et \(\gamma_{\alpha}=\dfrac{\alpha-P_{p_0}(T(X_{\bullet}) < c_{\alpha})}{P_{p_0}(T(X_{\bullet})=c_{\alpha})}\).

Remarque 10. Si nous avons observé \(T(x_{\bullet})=t_0\), comme \(\dfrac{T(x_{\bullet})}{n}\) est le meilleur estimateur de \(p\), la puissance a posteriori est donnée par :

Remarque 11. Si nous considérons les alternatives :

qui a été étudiée ci-avant, alors les tests \(\psi^{(1b)}_{\ast}\), au seuil \(\alpha\), et \(1-\psi^{(1a)}_{\ast}\), au seuil \(1-\alpha\), sont identiques.

Propriété 5. Si nous avons observé \(T(x_{\bullet})=t_0\), alors la décision avec les «\(p-\)valeurs» se prend de la manière suivante :

Pour une décision non aléatoire :

Remarque 12. Nous avons créé dans R quatre procédures. Les deux premières Test1bBern1p et Test1bBern1p_Int, permettent de réaliser le test avec une exécution non interactive et interactive respectivement. Les deux autres Puis1bBern1p et Puis1bBern1p_Int, permettent le calcul de la puissance avec une exécution non interactive et interactive respectivement.

Exemple 2. Nous reprenons le même exemple que celui du test asymptotique correspondant. Une entreprise doit livrer un lot de pièces. Un contrôle statistique de conformité est mis en place. Le lot est conforme si moins de \(4 \%\) des pièces sont défectueuses. Nous admettons que la situation la plus défavorable pour le receveur est celle de décider à tort que le lot est conforme. Donc nous nous proposons de tester l’alternative :

Nous avons, sur \(70\) pièces choisies au hasard dans le lot, \(3\) pièces non conformes. Nous fixons un seuil à \(0,05\) et nous exécutons, après les avoir compilées («sourcée» dans R), les procédures de la Remarque 12 ci-dessus.

Test1bBern1p(3,70,.04,.05), réponse :

Test de l’alternative : H0(1b)={ 0.04 ⩽ p} contre H1(1b)={p < 0.04 }.

Taille de l’échantillon : 70 ; nombre de «un» : 3 ; estimation du paramètre : 0.04286 .

Seuil du test : 0.05 ; valeur critique : 0 ; probabilité critique : 0.8709 .

Décision : «H0(1b) est vraie» .

La procédure interactive donne quant à elle :

Test1bBern1p_Int(), réponse :

Saisir le nombre de «un» : 3, réponse :

Saisir la taille de l’échantillon : 70, réponse :

Saisir la proportion P0 : .04, réponse :

Saisir seuil du test : .05, réponse :

les mêmes résultats que ceux de la procédure non interactive sont alors affichés.

La décision est «\({\cal H}_0^{(1b)}\) est vraie». Le test n’est pas significatif. Nous avons les mêmes conclusions que le test asymptotique. Notons que le test ici est le plus puissant. Il n’y a aucune raison objective de ne pas livrer le lot ; mais la décision est risquée. Pour être plus sûrs il faudrait refaire un échantillonnage.

La décision n’est pas aléatoire. A titre d’exemple nous présentons le même test, dans la même situation pratique, mais avec un échantillon différent. La taille de cet échantillon est \(n=20\) est le nombre de «un» est \(k=0\). Voici les résultats :

Test1bBern1p(0,20,.04,.05), réponse :

Test de l’alternative : H0(1b)={ 0.04 ⩽ p} contre H1(1b)={p < 0.04 }.

Taille de l’échantillon : 20 ; nombre de «un» : 0 ; estimation du paramètre : 0 .

Seuil du test : 0.05 ; valeur critique : 0 ; probabilité critique : 0.1131 .

La décision est aléatoire avec la simulation uniforme U= 0.5945 .

Le seuil réel si la décision aléatoire est rendue non aléatoire : 0.442 .

Décision : «H0(1b) est vraie» .

La puissance a posteriori est : 0.1131 .

La procédure interactive quant à elle est identique et donne les mêmes résultats. Le nombre de «un» observés et égal à la valeur critique \(k=c_{\alpha}=0\). La probabilité critique est \(\gamma_{\alpha}=0,1131\) ; comme la simulation uniforme est \(u=0,5945\), nous avons la même décision que celle à partir du premier échantillon. Cependant si nous décidons d’effectuer un test non aléatoire dans ce cas, la décision est «\({\cal H}_1^{(1b)}\) est vraie» mais le seuil réel du test est \(\alpha=0,442\), c’est-à-dire que le risque de première espèce est nettement plus grand.

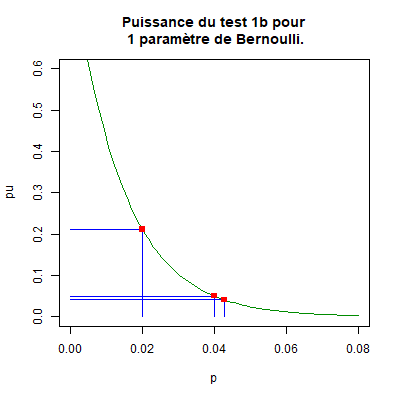

Nous revenons au premier échantillon. Nous calculons la puissance pour les points \(p=0,04286\) et \(p=0,1\) par exemple. Nous exécutons, après les avoir compilées («sourcée» dans R), les procédures de la Remarque 12 ci-dessus.

Puis1bBern1p(70,0.04,0.05,0.04286), réponse : 0.04058 .

Puis1bBern1p(70,0.04,0.05,0.02), réponse : 0.2117 .

La procédure interactive donne, par exemple :

Puis1bBern1p_Int(), réponse :

Saisir la taille de l’échantillon : 70, réponse :

Saisir la proportion P0 : .04, réponse :

Saisir seuil du test : .05, réponse :

Saisir le point P où calculer une approximation de la puissance asymptotique : 0.02, réponse : 0.2117 .

Le test exact étant U.P.P., c’est sa puissance qui est prépondérante et non celle du test asymptotique qui est approximative, même si elle est supérieure. Nous pouvons également tracer le graphique de la fonction puissance du test avec les commandes suivantes :

plot(

function(p)

Puis1bBern1p(70,0.04,0.05,P), 0, 0.08,

xlab="p",

ylab="pu",

ylim=

c(0,0.6),

main=Puissance du test 1b pour\n 1 paramètre de Bernoulli.",

col="green4");

x0=c(0.04,0.04,0.04286,0.04286,0.02,0.02);

y0=c(0,0.05,0,0.04058,0,.2117);

x1=c(0.04,0,0.04286,0,0.02,0);

y1=c(0.05,0.05,0.04058,0.04058,0.2117,0.2117);

segments(x0,y0,x1,y1,

col="blue");

points(

x=c(0.04,0.04286,0.02),

y=c(0.05,0.04058,0.2117),

col="red",

pch='.',

cex=8), réponse :

Nous avons marqué en rouge les points \((p_0\ ;\ \alpha)=(0,04\ ;\ 0,05)\), \((0,02\ ;\ pu_{\psi^{(1b)}_{\ast}}(0,.02))=(0,02\ ;\ 0,0.2117)\) et \((0,04286\ ;\ pu_{\psi^{(1b)}_{\ast}}(0,04286))=(0,04286\ ;\ 0,0.04058)\). Nous constatons, entre autres, que le test est de seuil \(0,05\) et sans biais. \(\ \square\)

Haut de la page.